La policía de San Francisco busca permiso para que sus robots usen fuerza letal

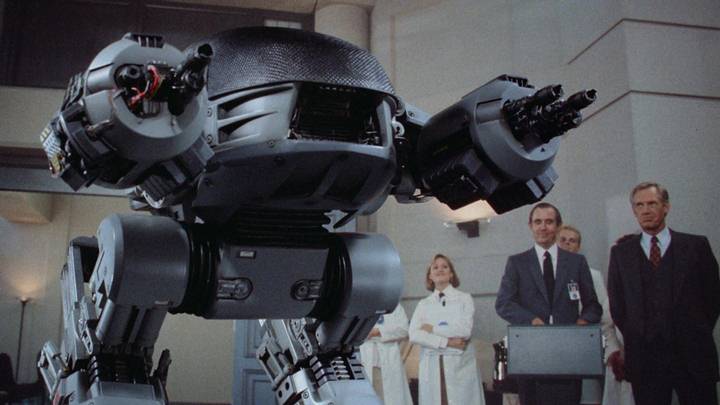

¿Acaso no hemos aprendido nada de Robocop?

Escena de película Robocop (1987), donde se muestra al ED-209, un robot de aplicación de la ley diseñado para suplantar a la policía.

El Departamento de Policía de San Francisco (SFPD) actualmente está solicitando permiso a la Junta de Supervisores de la ciudad para desplegar robots con el objetivo de eliminar a sospechosos que la policía considera lo suficientemente amenazantes como para representar un «riesgo de pérdida de vidas para miembros del público u oficiales, sobrepasando cualquier otra opción de fuerza disponible».

El borrador de la política, que fue redactado por el propio SFPD, también busca excluir «cientos de rifles de asalto de su inventario de armas de estilo militar y no incluir los costos de personal en el precio de sus armas», según un informe publicado por el Mission Local.

Esta propuesta ya ha visto una oposición significativa tanto dentro como fuera de la Junta. El supervisor Aaron Peskin, por ejemplo, inicialmente se opuso, añadiendo a la normativa que «los robots no se deben usar como fuerza contra ninguna persona». Sin embargo, el SFPD eliminó esa redacción en un borrador posterior. El Comité de Reglamentos de tres miembros, presidido por Peskin, luego aprobó por unanimidad ese borrador y lo adelantó a la Junta de Supervisores en pleno para una votación el próximo 29 de noviembre.

Peskin excusó su cambio de opinión al afirmar que «podría haber escenarios en los que el despliegue de fuerza letal —por parte de robots— fuera la única opción».

Los defensores y abogados que se oponen a la militarización de la policía están menos convencidos.

«Vivimos en un futuro distópico, en el que debatimos si la policía puede usar robots para ejecutar a ciudadanos sin un juicio, un jurado o un juez», dijo Tifanei Moyer, abogada sénior del Comité de Abogados por los Derechos Civiles del Área de la Bahía de San Francisco, quien lidera el trabajo de la organización sobre la mala conducta policial y la militarización. «Esto no es normal. Ningún profesional del derecho o residente ordinario debe comportarse como si fuera normal».

¿Cómo se usan los robots letalmente?

La fuerza policial actualmente mantiene una docena de robots controlados a distancia completamente funcionales, que generalmente se utilizan para inspecciones de área y eliminación de bombas. No obstante, como demostró el Departamento de Policía de Dallas en 2016, también son excelentes plataformas de lanzamiento de bombas. Las unidades de desactivación de bombas a menudo están equipadas con cartuchos de escopeta de fogueo que se usan para interrumpir por la fuerza el funcionamiento interno de un dispositivo explosivo; aunque no hay nada que impida que la policía use rondas reales si es necesario, como reconoció recientemente la policía de Oakland ante la junta de supervisión civil de esa ciudad.

Si bien San Francisco nunca ha permitido explícitamente que los robots quiten vidas humanas, las armas autónomas letales (LAW) son cada vez más comunes en la guerra moderna.

Escuadrón antibombas del SFPD desplegando un robot en la calle Valencia en 2019. Crédito: Abraham Rodríguez.

Las minas antipersona, una de las primeras iteraciones de armamento automatizado, han sido prohibidas desde 1997 —aunque eso no cuenta las que ya están en el suelo—; y las defensas totalmente automatizadas, como los sistemas Phalanx, han estado en uso desde la década de 1970. Los sistemas ofensivos autónomos, como los vehículos aéreos no tripulados y los drones de combate, se han utilizado durante años, pero siempre han requerido una «comando humano» para asumir la responsabilidad de disparar las armas.

Ahora, el SFPD, el mismo departamento que regularmente le cuesta a la ciudad acuerdos de seis cifras por su uso excesivo de la fuerza y se opone activamente a las investigaciones sobre su afinidad por las palizas con porras, quiere ejercer el mismo poder de vida o muerte sobre los civiles de San Francisco.

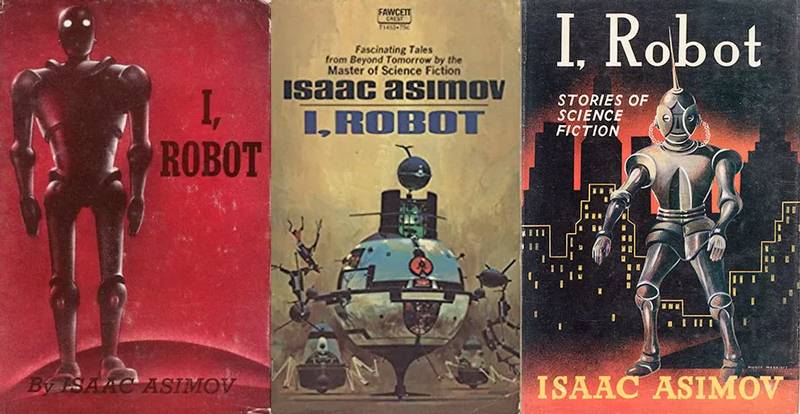

¿De aprobarse la solicitud, puede el SFPD estar violando las leyes de la robótica?

La respuesta, dado que los robots utilizados por el SFPD siempre requerirán supervisión y comandos emitidos por humanos para accionar contra otros humanos, es —técnicamente— NO. El conjunto de normas elaboradas por el escritor de ciencia ficción Isaac Asimov, entre las que se incluye «un robot no hará daño a un ser humano, ni por inacción permitirá que un ser humano sufra daño», aplican más bien a robots que tengan no solo autonomía, sino inteligencia artificial.

Aquí cabe recordar que las tres leyes de Asimov deben ser programadas por los humanos creadores y que son, por el momento, más filosofía que ley. El avance de la IA, empero, ha aumentado el interés en desarrollar directrices y salvaguardias para su funcionamiento. Aunque muchos creen que será algo difícil de aplicar.

Las Tres Leyes de la Robótica son un conjunto de reglas ideadas por el autor de ciencia ficción Isaac Asimov. Las reglas se introdujeron en su cuento corto de 1942 ‘Runaround’ (incluido en la colección de 1950 I, Robot), aunque se habían presagiado en algunos cuentos anteriores.

«El desarrollo de la IA es un negocio, y las empresas son notoriamente desinteresadas en las salvaguardas fundamentales, especialmente las filosóficas. (Algunos ejemplos rápidos: la industria del tabaco, la industria automotriz, la industria nuclear). Ninguno de ellas ha dicho desde el principio que las salvaguardias fundamentales son necesarias, cada uno de ellas ha resistido las salvaguardias impuestas desde el exterior y ninguna ha aceptado un edicto absoluto en contra de causar daño a los humanos», comentó el autor de ciencia ficción Robert J. Sawyer, quien sostiene que, dado que el ejército de EE.UU. es una fuente importante de financiación para la investigación robótica, es poco probable que tales leyes se incluyan en sus diseños.

Solo esperemos que no pasemos de un escenario «Robocop» a un escenario «Terminator» demasiado rápido…

Fuente: Engadget/Mission Local. Edición: MP.