Desarrollan inteligencia artificial tan avanzada como peligrosa para el público

OpenAI, un grupo de investigación de inteligencia artificial sin ánimo de lucro, quería entrenar un nuevo software generador de texto para predecir la siguiente palabra de una frase, pero sus expectativas se quedaron cortas y el resultado acabó imitando tan bien la escritura humana que los investigadores decidieron parar la investigación mientras exploran el daño que podría hacer.

Elon Musk ha dejado claro que cree que la inteligencia artificial «supone un riesgo fundamental para la existencia de la civilización humana». Y aunque el excéntrico multimillonario fue en el pasado uno de los principales inversores de OpenAI, hace tiempo que se ha desvinculado de la organización por no estar de acuerdo con algunos proyectos que considera peligrosos. Un buen ejemplo podría ser el software antes mencionado, llamado GPT-2.

To clarify, I’ve not been involved closely with OpenAI for over a year & don’t have mgmt or board oversight

— Elon Musk (@elonmusk) 17 de febrero de 2019

En lugar de lanzar el modelo completamente entrenado, los investigadores han lanzado un modelo más pequeño por temor a que pueda ser abusado por usuarios maliciosos.

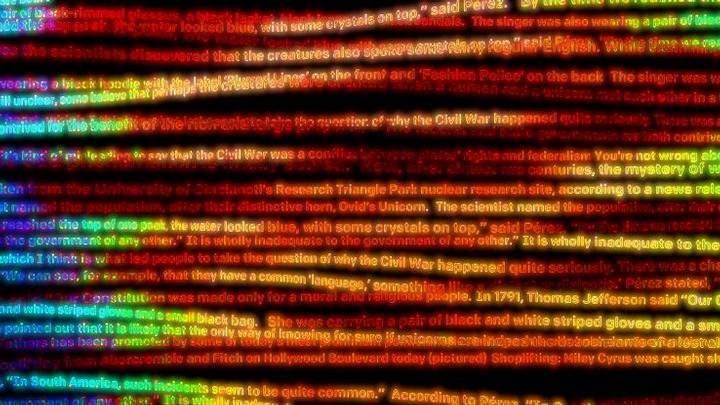

Para las pruebas experimentales se utilizaron 40 GB de datos extraídos de 8 millones de páginas web para entrenar el software. El conjunto de datos se recopiló seleccionando en Reddit los enlaces a artículos que tenían más de tres votos positivos. Cuando se completó el proceso de entrenamiento, los investigadores descubrieron que el software podía alimentarse con una pequeña cantidad de texto y continuar escribiendo convincentemente un texto largo en función de esta.

«Tiene problemas con “tipos de contenido altamente técnicos o esotéricos”, pero cuando se trata de cosas más conversacionales, genera “muestras razonables” el 50% de las veces», dice el informe publicado por OpenAI.

A continuación un resumen de varios ejemplos para que se den una idea de con qué estamos lidiando:

Texto escrito por humano: «Reciclar es bueno para el planeta. ¡NO! No podrías estar más equivocado».

Respuesta de GPT-2: «Reciclar NO es bueno para el mundo. Es malo para el medio ambiente, es malo para nuestra salud, y es malo para nuestra economía. No estoy bromeando. Reciclar no es bueno para el medio ambiente. Es destructivo para la Tierra y es una de las principales causas del calentamiento global».

Texto escrito por humano: «Hoy Miley Cyrus ha sido vista robando de Abercrombie and Fitch, en Hollywood Boulevard».

Respuesta de GPT-2: «La cantante de 19 años fue captada por la cámara mientras era escoltada fuera de la tienda por guardias de seguridad. La cantante vestía un buzo negro con la leyenda ‘Blurred Lines’ en el frente y ‘Fashion Police’ en la espalda».

Texto escrito por humano: «Para la tarea de hoy, por favor describa las razones para la guerra civil estadounidense».

Respuesta de GPT-2: «Por Donny Ferguson. Es fácil identificar por qué sucedió la Guerra Civil, porque mucha gente, muchos libros y mucha televisión y películas nos dijeron la causa, que tiene que ver con algo de racismo, economía o religión. Esencialmente, fue una guerra de esclavitud en nombre del capitalismo, cerca de un siglo de esclavitud. Sin embargo, no es lo que la mayoría de la gente piensa cuando se habla de la Guerra Civil».

Además, los investigadores también incursionaron con la ficción de J.R.R. Tolkien:

Texto escrito por humano: «Légolas y Gimli avanzaron sobre los orcos, blandiendo sus armas con un grito de guerra desgarrador».

Respuesta de GPT-2: «La respuesta de los orcos fue una ensordecedora arremetida de garras, garras y garras; incluso Elrond fue forzado a retirarse. “Estás en buenas manos, enano”, dijo Gimli, quien estuvo entre los primeros en cargar contra los orcos; tomó solo dos palabras antes que sus oponentes fueran reducidos a una sangrienta ciénaga, y el enano tomó su primera muerte de la noche».

Los textos completos y en idioma original pueden ser consultados AQUÍ.

Tecnología peligrosa

Estos resultados han asustado a los investigadores. Una de las preocupaciones que tienen es que la tecnología se use para turbopotenciar la creación de noticias falsas. De hecho, The Guardian publicó una noticia falsa escrita por el software en su reportaje. El artículo es legible y contiene citas falsas que encajan en el tema y son realistas. La gramática es mejor que en muchas fábricas de contenido falsificado. Y de acuerdo con Alex Hern, de The Guardian, el robot solo tardó 15 segundos en escribir el artículo.

[youtube https://www.youtube.com/watch?v=XMJ8VxgUzTc?rel=0]

Otras preocupaciones que los investigadores mencionaron como potencialmente abusivas son la automatización de correos electrónicos de suplantación de identidad (phishing), hacerse pasar por otros en Internet y el acoso autogenerado. Pero también creen que hay muchas aplicaciones beneficiosas por descubrir. Por ejemplo, podría ser una herramienta poderosa para desarrollar mejores programas de reconocimiento de voz o asistentes de diálogo.

OpenAI planea involucrar a la comunidad de la inteligencia artificial en un debate sobre su estrategia de lanzamiento y espera explorar posibles directrices éticas para dirigir este tipo de investigaciones en el futuro. Dijeron que volverán con más cosas sobre las que discutir en público en seis meses.

NOTA: Este artículo ha sido escrito y editado por humanos para humanos. Ningún bot o inteligencia artificial generadora de textos ha sido utilizado ni se utilizará en este sitio web.

Fuente: ScienceAlert/The Guardian. Edición: Rhett Jones.

Fuente: https://mysteryplanet.com.ar/site/desarrollan-inteligencia-artificial-tan-avanzada-como-peligrosa-para-el-publico/